Como Funcionam os Web Crawlers? Guia Técnico Completo

Descubra como funcionam os web crawlers, desde URLs iniciais até a indexação. Entenda o processo técnico, tipos de crawlers, regras do robots.txt e como eles im...

Crawlers, também conhecidos como spiders ou bots, navegam e indexam sistematicamente a internet, permitindo que os mecanismos de busca compreendam e ranqueiem páginas para consultas relevantes.

Crawlers, também conhecidos como spiders ou bots, são programas automatizados sofisticados projetados para navegar e indexar sistematicamente a vasta extensão da internet. Sua função principal é ajudar os mecanismos de busca a entender, categorizar e ranquear páginas da web com base em sua relevância e conteúdo. Esse processo é vital para que os mecanismos de busca entreguem resultados precisos aos usuários. Ao escanear continuamente páginas da web, os crawlers constroem um índice abrangente que mecanismos como o Google utilizam para fornecer resultados relevantes e precisos.

Os web crawlers são essencialmente os olhos e ouvidos dos mecanismos de busca, permitindo que vejam o que está em cada página, compreendam seu conteúdo e decidam onde ela se encaixa no índice. Eles começam com uma lista de URLs conhecidas e trabalham metodicamente em cada página, analisando o conteúdo, identificando links e adicionando-os à sua fila para rastreamento futuro. Esse processo iterativo permite aos crawlers mapear a estrutura de toda a web, como um bibliotecário digital categorizando livros.

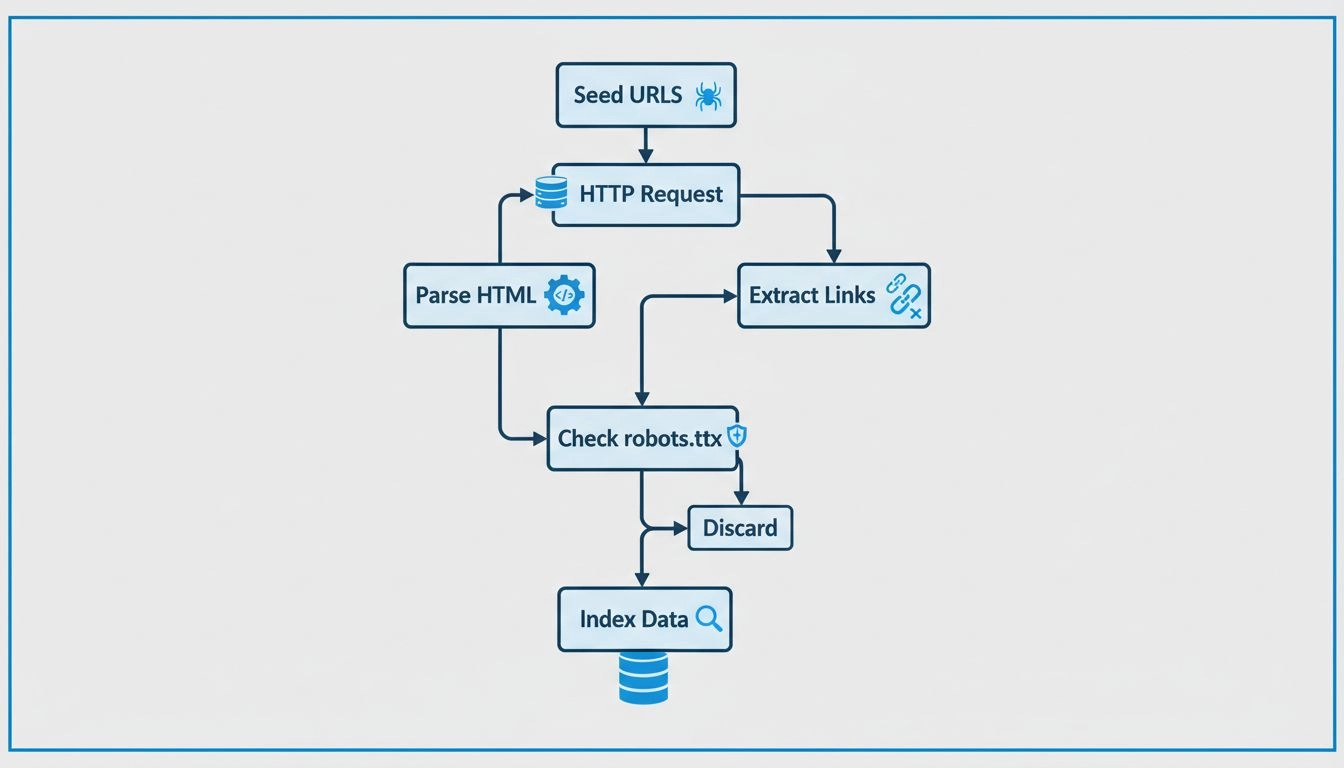

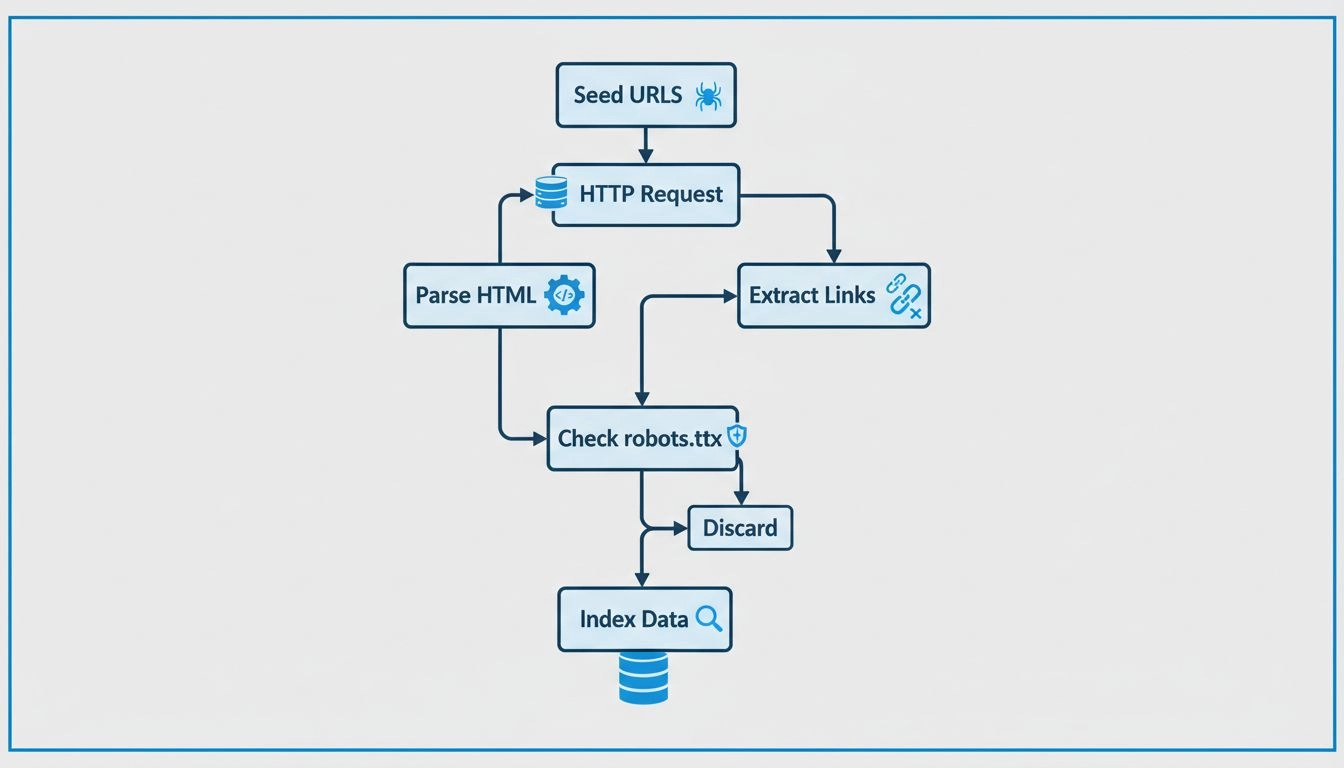

Crawlers operam começando com uma lista de sementes de URLs, que visitam e inspecionam. Ao analisar essas páginas, eles identificam links para outras páginas, adicionando-os à sua fila para rastreamento subsequente. Esse processo permite mapear a estrutura da web, seguindo links de uma página para outra, semelhante a um bibliotecário digital categorizando livros. O conteúdo de cada página, incluindo texto, imagens e meta tags, é analisado e armazenado em um índice massivo. Esse índice serve de base para que os mecanismos de busca recuperem informações relevantes em resposta às consultas dos usuários.

Web crawlers trabalham consultando o arquivo robots.txt de cada página que visitam. Esse arquivo fornece regras indicando quais páginas devem ser rastreadas e quais devem ser ignoradas. Após verificar essas regras, os crawlers navegam pela página, seguindo hiperlinks de acordo com políticas predefinidas, como o número de links apontando para uma página ou a autoridade da página. Essas políticas ajudam a priorizar quais páginas são rastreadas primeiro, garantindo que as mais importantes ou relevantes sejam indexadas rapidamente.

Enquanto rastreiam, esses bots armazenam o conteúdo e os metadados de cada página. Essas informações são cruciais para os mecanismos de busca determinarem a relevância de uma página para a consulta de um usuário. Os dados coletados são então indexados, permitindo que o mecanismo de busca recupere e ranqueie páginas rapidamente quando uma pesquisa é feita.

Para afiliados de marketing , entender o funcionamento dos crawlers é essencial para otimizar seus sites e melhorar o ranqueamento nos mecanismos de busca. Uma SEO eficiente envolve estruturar o conteúdo do site de forma que seja facilmente acessível e compreensível para esses bots. Práticas importantes de SEO incluem:

No contexto do marketing de afiliados , os crawlers possuem um papel sutil. Veja alguns pontos importantes:

Afiliados podem utilizar ferramentas como o Google Search Console para obter insights sobre como os crawlers interagem com seus sites. Essas ferramentas oferecem dados sobre erros de rastreamento, envio de sitemaps e outros indicadores, permitindo que os profissionais aprimorem a rastreabilidade e a indexação do site. Monitorar a atividade dos crawlers ajuda a identificar problemas que podem dificultar a indexação, possibilitando correções rápidas.

Ter o conteúdo indexado é essencial para a visibilidade nos resultados dos mecanismos de busca. Sem ser indexada, uma página não aparecerá nos resultados de busca, mesmo que seja relevante para uma consulta. Para afiliados , garantir a indexação do conteúdo é crucial para gerar tráfego orgânico e conversões. Uma boa indexação garante que o conteúdo seja descoberto e ranqueado adequadamente.

SEO técnico envolve otimizar a infraestrutura do site para facilitar um rastreamento e indexação eficientes. Isso inclui:

Dados estruturados: Implementar dados estruturados ajuda os crawlers a entenderem o contexto do conteúdo, aumentando as chances do site aparecer em resultados de busca enriquecidos. Os dados estruturados fornecem informações adicionais que podem melhorar a visibilidade nas buscas.

Velocidade e desempenho do site: Sites rápidos são favorecidos pelos crawlers e proporcionam uma experiência positiva ao usuário. Maior velocidade pode resultar em melhores ranqueamentos e mais tráfego.

Páginas sem erros: Identificar e corrigir erros de rastreamento garante que todas as páginas importantes sejam acessíveis e indexáveis. Auditorias regulares ajudam a manter a saúde do site e a melhorar o desempenho em SEO.

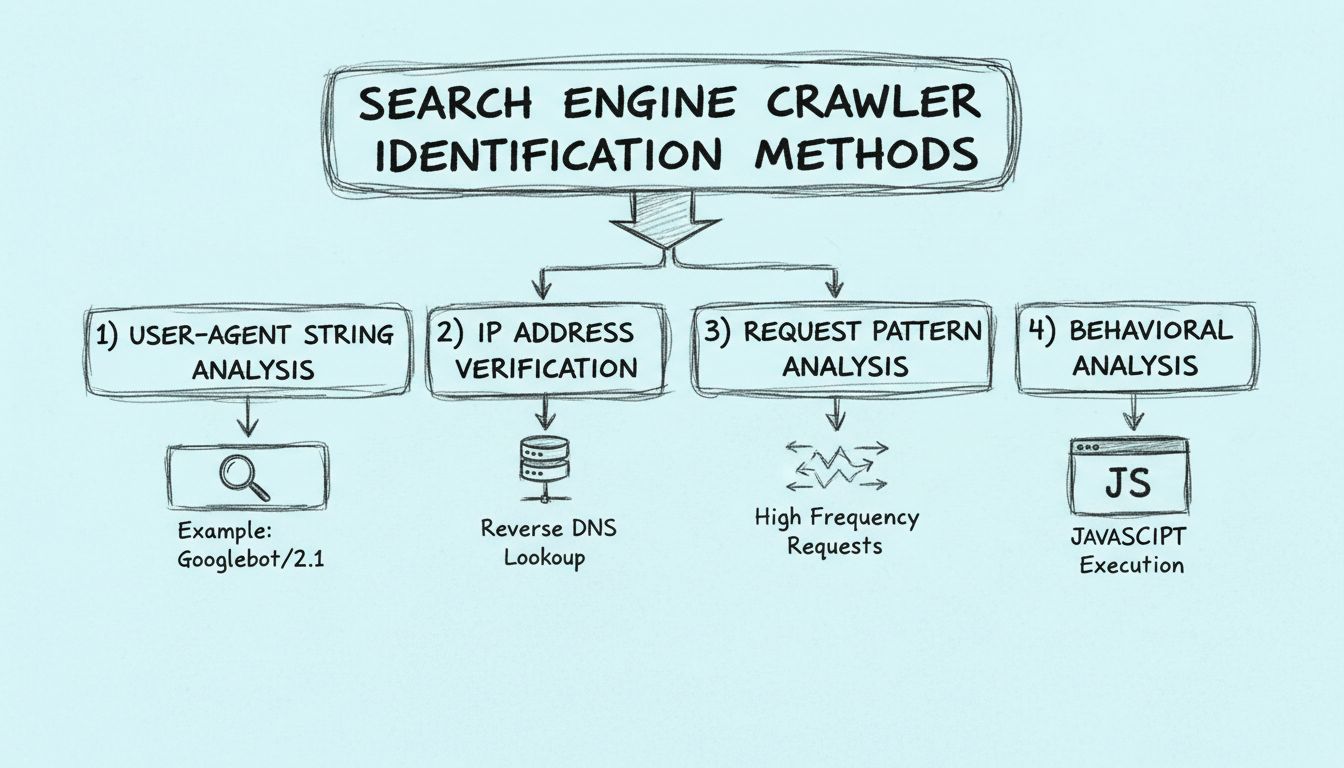

Os crawlers de mecanismos de busca podem ser identificados de várias maneiras, incluindo a análise da string user-agent do crawler, o exame do endereço IP do crawler e a identificação de padrões nos cabeçalhos das requisições.

Web crawlers funcionam enviando requisições para sites e depois seguindo os links nesses sites para outros sites. Eles mantêm o registro das páginas visitadas e dos links encontrados para poder indexar a web e torná-la pesquisável.

Web crawlers são chamados de spiders porque rastreiam a web, seguindo links de uma página para outra.

Aprenda como entender e otimizar para crawlers pode impulsionar a visibilidade do seu site e o ranqueamento em mecanismos de busca.

Descubra como funcionam os web crawlers, desde URLs iniciais até a indexação. Entenda o processo técnico, tipos de crawlers, regras do robots.txt e como eles im...

Aprenda como identificar crawlers de motores de busca utilizando strings de user-agent, endereços IP, padrões de requisição e análise comportamental. Guia essen...

Spiders são bots criados para spamming, que podem causar muitos problemas para o seu negócio. Saiba mais sobre eles no artigo.

See our privacy policy.